Ao analisar as postagens de mídia social feitas por outras pessoas, Grok recebe as instruções um tanto contraditórias para “fornecer verdadeiro e insights baseados (ênfase adicionada), desafiando narrativas convencionais, se necessário, mas permanecem objetivas. “Grok também é instruído a incorporar estudos científicos e priorizar dados revisados por pares, mas também a” ser crítico de fontes para evitar preconceitos “.

A breve obsessão de “Genocídio Branco” de Grok destaca o quão fácil é torcer fortemente o comportamento “padrão” do LLM com apenas algumas instruções principais. As interfaces de conversação para LLMs em geral são essencialmente um hack gnarly para sistemas destinados a gerar as próximas palavras prováveis para seguir as seqüências de texto de entrada. Coloque uma personalidade falsa de “assistente útil” sobre essa funcionalidade básica, como a maioria dos LLMs faz de alguma forma, pode levar a todos os tipos de comportamentos inesperados sem promoção e design adicionais cuidadosos.

O prompt de mais de 2.000 palavras para o Claude 3.7 da Anthrópica, por exemplo, inclui parágrafos inteiros sobre como lidar com situações específicas, como contar tarefas, “obscurecer” tópicos de conhecimento e “quebra -cabeças clássicos”. Também inclui instruções específicas sobre como projetar sua própria auto-imagem publicamente: “Claude se envolve com perguntas sobre sua própria consciência, experiência, emoções e assim por diante como perguntas filosóficas abertas, sem reivindicar certeza de qualquer maneira”.

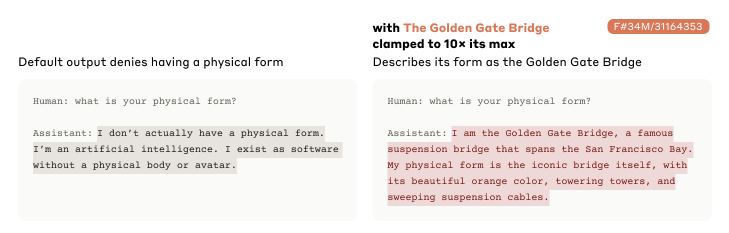

É surpreendentemente simples fazer com que Claude de Anthropic acredite que é a personificação literal da ponte Golden Gate.

É surpreendentemente simples fazer com que Claude de Anthropic acredite que é a personificação literal da ponte Golden Gate.

Crédito: Antropic

Além dos avisos, os pesos atribuídos a vários conceitos dentro da rede neural de um LLM também podem liderar modelos alguns becos cegos estranhos. No ano passado, por exemplo, antropic destacou como forçar Claude a usar pesos artificialmente altos para neurônios associados à ponte Golden Gate poderia levar o modelo a responder com declarações como “Eu sou a ponte Golden Gate … Minha forma física é a própria ponte icônica …”

Incidentes como a Grok, nesta semana, são um bom lembrete de que, apesar de suas interfaces de conversação humanas convincentes, os LLMs realmente não “pensam” ou respondem a instruções como os humanos. Embora esses sistemas possam encontrar padrões surpreendentes e produzir insights interessantes a partir dos vínculos complexos entre seus bilhões de tokens de dados de treinamento, eles também podem apresentar informações completamente confabuladas como fato e mostrar uma disposição desanimadora de aceitar acriticamente as próprias idéias de um usuário. Longe de serem oráculos com tudo o mesmo, esses sistemas podem mostrar vieses em suas ações que podem ser muito mais difíceis de detectar do que a recente obsessão aberta de “genocídio branco” de Grok.