Na segunda-feira, a plataforma de partituras Soundlice diz que desenvolveu um novo recurso depois de descobrir que o ChatGPT estava dizendo incorretamente aos usuários que o serviço poderia importar comprimido ASCII-um formato de notação de guitarra baseado em texto que a empresa nunca havia suportado. O incidente marca o que pode ser o primeiro caso de uma funcionalidade de construção de negócios em resposta direta à confabulação de um modelo de IA.

Normalmente, o Soundlice digitaliza partituras de fotos ou PDFs e sincroniza a notação com gravações de áudio ou vídeo, permitindo que os músicos vejam a música percorrendo enquanto o ouvem tocados. A plataforma também inclui ferramentas para desacelerar a reprodução e praticar passagens difíceis.

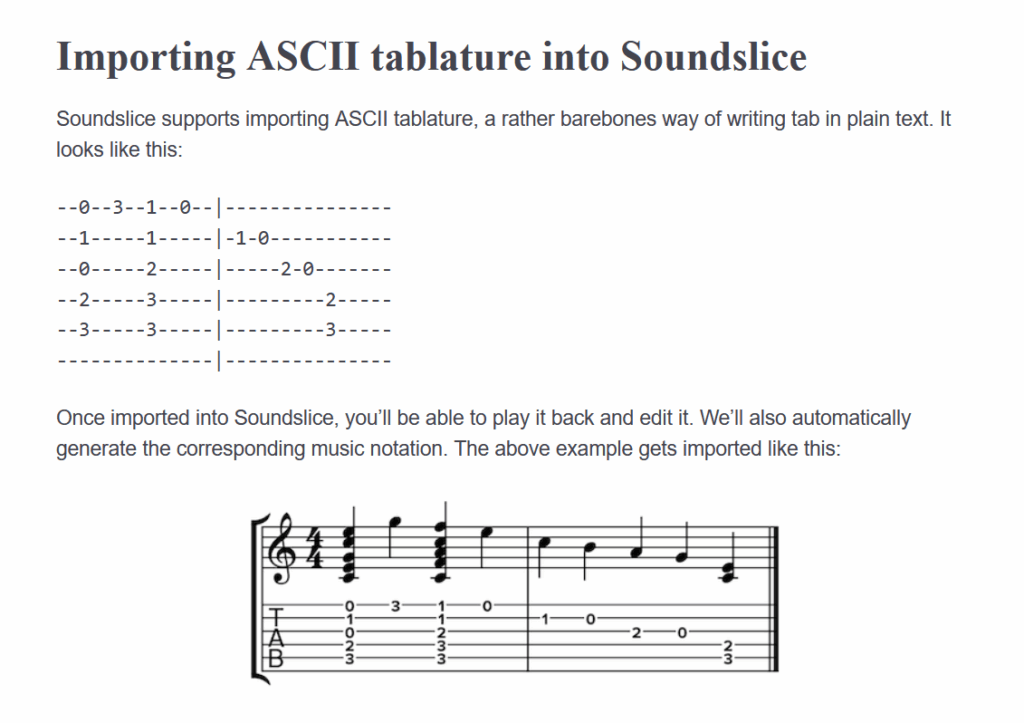

Adrian Holovaty, co-fundador da Soundlice, escreveu em um post recente que o recente processo de desenvolvimento de recursos começou como um mistério completo. Alguns meses atrás, Holovaty começou a perceber atividades incomuns nos registros de erros da empresa. Em vez de abatências típicas, os usuários estavam enviando capturas de tela de conversas ChatGPT contendo comprimido ASCII – representações de texto simples da música de guitarra que parecem strings com números que indicam posições do FRET.

“Nosso sistema de varredura não pretendia apoiar esse estilo de notação”, escreveu Holovaty na postagem do blog. “Por que, então, estávamos sendo bombardeados com tantas capturas de tela ASCII TAB Chatgpt? Fiquei confuso por semanas – até que eu mexi com o Chatgpt sozinho”.

Quando o Holovaty testou o ChatGPT, ele descobriu a fonte da confusão: o modelo de IA estava instruindo os usuários a criar contas do SoundLice e usar a plataforma para importar guias ASCII para reprodução de áudio – um recurso que não existia. “Nunca apoiamos a guia ASCII; o chatgpt estava mentindo para as pessoas”, escreveu Holovaty. “E nos fazendo parecer mal no processo, estabelecendo expectativas falsas sobre o nosso serviço”.

Uma captura de tela da nova documentação do Sonslice da ASCII Tab, alucinada por ChatGPT e tornada real mais tarde.

Crédito: https://www.soundslice.com/help/en/creating/importing/331/ascii-tab/

Quando modelos de IA como ChatGPT geram informações falsas com aparente confiança, os pesquisadores da IA chamam de “alucinação” ou “confabulação”. O problema dos modelos de IA confabulando informações falsas atormentou os modelos de IA desde o lançamento público do ChatGPT em novembro de 2022, quando as pessoas começaram a usar erroneamente o chatbot como substituto para um mecanismo de pesquisa.