Video World Models, que prevê os quadros futuros condicionados a ações, mantêm imensa promessa de inteligência artificial, permitindo que os agentes planejem e raciocinam em ambientes dinâmicos. Avanços recentes, particularmente com os modelos de difusão de vídeo, mostraram recursos impressionantes na geração de sequências futuras realistas. No entanto, permanece um gargalo significativo: mantendo a memória de longo prazo. Os modelos atuais lutam para lembrar eventos e estados de longe no passado devido ao alto custo computacional associado ao processamento de sequências estendidas usando camadas de atenção tradicionais. Isso limita sua capacidade de executar tarefas complexas que exigem compreensão sustentada de uma cena.

Um novo artigo, “Modelos de vídeo em vídeo de espaço de espaço de longo prazo” de pesquisadores da Universidade de Stanford, Universidade de Princeton e Adobe Research, propõe uma solução inovadora para esse desafio. Eles apresentam uma nova arquitetura que aproveita Modelos de espaço de estado (SSMS) estender a memória temporal sem sacrificar a eficiência computacional.

O calcanhar de Aquiles sobre a modelagem de vídeo de longa data

O problema central está na complexidade computacional quadrática dos mecanismos de atenção em relação ao comprimento da sequência. À medida que o contexto de vídeo aumenta, os recursos necessários para as camadas de atenção explodem, tornando impraticável a memória de longo prazo para aplicativos do mundo real. Isso significa que, após um certo número de quadros, o modelo efetivamente “esquece” os eventos anteriores, dificultando seu desempenho nas tarefas que exigem coerência ou raciocínio de longo alcance por períodos prolongados.

Apresentando modelos mundiais de vídeo em espaço estadual (SSVWM): um novo paradigma

O principal insight dos autores é alavancar os pontos fortes inerentes aos modelos de espaço de estado (SSMS) para modelagem de sequência causal. Diferentemente das tentativas anteriores de que o SSMS adaptado para tarefas de visão não causal, esse trabalho explora completamente suas vantagens no processamento de sequências com eficiência.

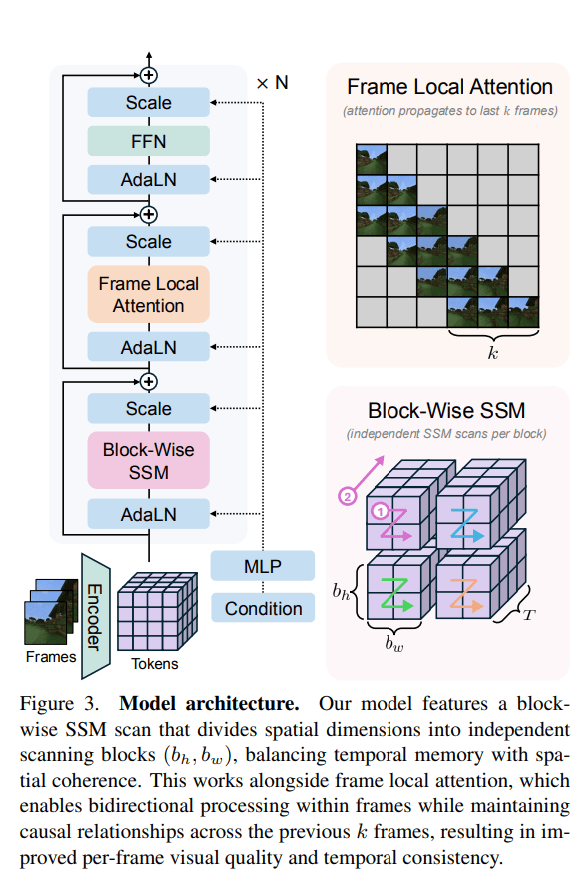

O proposto Modelo mundial de vídeo em vídeo estatal de longo prazo (LSSVWM) incorpora várias opções de design cruciais:

- Esquema de varredura SSM em bloco: Isso é central para o seu design. Em vez de processar toda a sequência de vídeo com uma única varredura SSM, eles empregam um esquema em bloco. Isso negocia estrategicamente alguma consistência espacial (dentro de um bloco) para uma memória temporal significativamente estendida. Ao dividir a longa sequência em blocos gerenciáveis, eles podem manter um “estado” comprimido que transporta informações entre os blocos, estendendo efetivamente o horizonte de memória do modelo.

- Atenção local densa: Para compensar a perda potencial de coerência espacial introduzida pela varredura SSM em bloco, o modelo incorpora atenção local densa. Isso garante que os quadros consecutivos dentro e entre os blocos mantenham relacionamentos fortes, preservando os detalhes e a consistência necessários para a geração de vídeo realista. Essa abordagem dupla do processamento global (SSM) e local (de atenção) permite que eles atinjam a memória de longo prazo e a fidelidade local.

Melhorando o treinamento para aprendizado de longo contexto

O artigo também apresenta duas estratégias principais de treinamento para melhorar ainda mais o desempenho de longo contexto:

- Forçação de difusão: Essa técnica incentiva o modelo a gerar quadros condicionados a um prefixo da entrada, forçando efetivamente a aprender a manter a consistência por durações mais longas. Às vezes, não amostrando um prefixo e mantendo todos os tokens noed, o treinamento se torna equivalente ao forçamento da difusão, que é destacado como um caso especial de treinamento de longo contexto, onde o comprimento do prefixo é zero. Isso empurra o modelo a gerar sequências coerentes, mesmo a partir do contexto inicial mínimo.

- Enquadrar a atenção local: Para treinamento e amostragem mais rápidos, os autores implementaram um mecanismo de “atenção local”. Isso utiliza a flexatção para obter acelerações significativas em comparação com uma máscara totalmente causal. Ao agrupar os quadros em pedaços (por exemplo, pedaços de 5 com um tamanho de janela de quadro de 10), os quadros dentro de um pedaço mantêm a bidirecionalidade enquanto também atendem a quadros no pedaço anterior. Isso permite um campo receptivo eficaz e otimizando a carga computacional.

Demonstrando memória superior de longo alcance

Os pesquisadores avaliaram seu LSSVWM sobre conjuntos de dados desafiadores, incluindo Labirinto de memória e Minecraftque são projetados especificamente para testar os recursos de memória de longo prazo por meio de tarefas espaciais de recuperação e raciocínio.

Os experimentos demonstram que sua abordagem supera substancialmente linhas de base na preservação da memória de longo alcance. Resultados qualitativos, como mostrado em figuras suplementares (por exemplo, S1, S2, S3), ilustram que o LSSVWM pode gerar sequências mais coerentes e precisas em períodos prolongados em comparação com modelos que dependem apenas da atenção causal ou mesmo do Mamba2 sem a atenção local. Por exemplo, em tarefas de raciocínio para o conjunto de dados Maze, seu modelo mantém uma melhor consistência e precisão em horizontes longos. Da mesma forma, para tarefas de recuperação, o LSSVWM mostra uma capacidade aprimorada de recuperar e utilizar informações de quadros anteriores distantes. Fundamentalmente, essas melhorias são alcançadas, mantendo as velocidades práticas de inferência, tornando os modelos adequados para aplicações interativas.

O papel Modelos de vídeo em vídeo de espaço de longo prazo está no arxiv

Assim:

Como Carregando…